“The Malicious Use of Artificial Intelligence: Forecasting, Prevention, and Mitigation” è il titolo di un report che, tra i primi, affronta in modo sistematico il tema dell’uso doloso dell’Intelligenza Artificiale (AI). Il documento è la sintesi delle attività di 26 ricercatori di 14 diverse prestigiose organizzazioni accademiche, della società civile e dell’industria. Hanno infatti collaborato allo studio, tra gli altri, il “Future of Humanity Institute” Istituto di ricerche multidisciplinari sull’Existential Risk della University of Oxford; il “Centre for the Study of Existential Risk“, impegnato nello studio e nella mitigazione del rischio esistenziale che può condurre all’estinzione del genere umano o al collasso della civilizzazione, della Cambridge University; il “Center for a New American Security“, che elabora politiche basate su principi forti e pragmatici in merito alla sicurezza nazionale; l'”Electronic Frontier Foundation“, organizzazione no profit che si occupa dei diritti digitali, con base in California e “OpenAI“, società di ricerca no profit impegnata nel campo dell’intelligenza artificiale sicura.

Nel contesto dello studio, l’accezione data alla terminologia “malicious use” è particolarmente esteso ed implica le problematiche di sicurezza che possono avere impatto sui singoli, sui gruppi e sull’intera società. Nello studio, la cui realizzazione ha richiesto più di un anno, si sottolinea fortemente come l’argomento della sicurezza in ambito AI sia stato affrontato molto più approfonditamente col presupposto che le problematiche nascono da deviazioni rispetto a quanto atteso, una sorta di effetto collaterale, o per errore.

Questo approccio è da ritenersi decisamente non corretto ed è del tutto insufficiente ridurre l’analisi delle minacce in questo ambito al risultato di un “bias” (distorsione nell’interpretazione) nelle applicazioni o nell’apprendimento. Sono infatti ormai già palesi alcuni scenari in cui l’uso di soluzioni di AI è progettualmente e volontariamente doloso. Si fa quindi più pressante l’esigenza di pensare e proporre metodologie, modalità di sviluppo o di certificazione che forniscano nuovi strumenti e procedure per prevedere, prevenire o mitigare queste minacce alla sicurezza.

Lo studio propone una serie di raccomandazioni da tener in forte considerazione avendo ben presenti gli scenari di possibile sviluppo e diffusione di soluzioni AI. L’orizzonte temporale cui si fa riferimento non è affatto proiettato nel futuro. Il tema è infatti già attuale, anzi semmai si è accumulato un certo ritardo, e le riflessioni nascono dalla conoscenza di tecnologie AI già disponibili o che saranno plausibilmente di largo utilizzo nei prossimi tre o cinque anni. In sintesi, nel report si raccomanda di approfondire ricerca e dibattito in quattro aree di riferimento:

1. Assimilare quanto già ritenuto come “best practices” in ambiti di ricerca attigui

2. Esplorare diversi modelli collaborativi di ricerca e diffusione della conoscenza

3. Promuovere fortemente la cultura della responsabilità

4. Sviluppare contestualmente sia modelli tecnologici “di produzione” che “di gestione”

Quando si ragiona dei domini nei quali l’uso doloso della AI costituisce una minaccia, il primo contesto cui si è portati a pensare è quello della “digital security”, ma il report ne presenta altri due: la “phisical security” e la “political security”. L’ambito della sicurezza fisica riguarda i sistemi tangibili, strettamente correlati con attuatori e componenti hardware in grado di interagire con ambienti, cose e persone. I campi applicativi sono davvero molto ampi e si estendono dal delicatissimo tema delle armi a controllo automatico alle varie declinazioni dell’utilizzo dei droni. Scenari assolutamente plausibili sono riconducibili al sovvertimento del funzionamento di dispositivi e strumenti, si pensi alla possibilità di alterare i comportamenti delle auto a guida autonoma.

Gli eventi che si sono verificati negli ultimi mesi hanno reso più evidenti alcune delle possibili ripercussioni di minacce e problematiche di sicurezza in ambito AI applicata alla “political security”. La raccolta di enormi quantità di dati e la crescente capacità di dedurne informazioni ha enormi positive ripercussioni, ma tra gli effetti collaterali più temibili quello di acquisire la capacità di sviluppare strumenti di sorveglianza di massa che possano limitare le libertà civili e personali. Inoltre, la capacità di forgiare notizie, distribuirle in modo mirato o limitarne la diffusione espone a problematiche di censura, da un lato, o di vera e propria propaganda digitale, all’altro estremo; con la possibilità, in ogni caso, di creare sensibili distorsioni e generare effetti di manipolazione sociale e politica. In questo senso, l’AI può divenire strumento temibile perché consente di svolgere analisi mirate allo studio dei comportamenti di singole persone, dei gruppi e delle organizzazioni politiche.

Una delle indicazioni più forti dello studio è infatti una sollecitazione rivolta proprio ai decisori politici perché collaborino più attivamente e più strettamente con tecnici e ricercatori, in modo che sviluppino maggiori sensibilità e consapevolezza sul tema della sicurezza in ambito AI. Da più parti, infatti, viene sempre più spesso rimproverato ai primi un eccessivo “ottimismo tecnologico”, ai secondi un atteggiamento di irresponsabilità nelle forme applicative delle loro soluzioni tecnologiche. Secondo quanto evidenziato, ricercatori e tecnici dovrebbero riflettere sul possibile uso doloso delle proprie ricerche già nelle fasi della loro pianificazione. Ad esempio, dovrebbe essere condotta una vera e propria analisi dei rischi pre-pubblicazione per valutarne le forme più opportune, un po’ come già accade nell’ambito della cybersecurity o delle biotecnologie. Con un simile approccio si avrebbe “by default” la possibilità di mitigarne le problematiche, anche semplicemente definendo i criteri di diffusione, e limitare eventuali utilizzi “non costruttivi”.

L’estrema apertura e la sollecita condivisione dei risultati nell’ambito della ricerca tecnologica in AI sta favorendo rapidi e considerevoli progressi, ma la diffusione espone contestualmente a rischi di utilizzo doloso. Il tema è ovviamente tipico della ricerca tout court e in questo caso costituisce anche un’estensione della problematica del “dual use” di beni e tecnologie: “Artificial Intelligence is dual-use in the same sense that human intelligence is”.

In settori di ricerca diversi è ormai grande il numero di Paesi che hanno già definito norme in questo senso. In Italia, ad esempio, il Ministero dello Sviluppo Economico pubblica sul proprio sito delle chiare indicazioni sulla modalità di importazione ed esportazione di beni e tecnologie che possono avere applicazioni in ambito civile ma anche militare, “dual use” appunto. Anche nella ricerca in AI, ove sia possibile, è auspicabile mutuare lo standard di comportamento di settori più maturi, come quello della “cybersecurity”: metodologie di verifica formale e di divulgazione responsabile delle eventuali vulnerabilità rilevate o di minacce individuate.

Nel tentativo di trarre vantaggio dalla diversificazione delle sensibilità sui temi della sicurezza, dell’etica e della responsabilità nell’innovazione tecnologica, un’ulteriore indicazione presente nello studio riguarda la necessità di estendere il dominio delle expertise e il numero delle parti interessate nei singoli progetti di ricerca, in modo da coinvolgere una pluralità di soggetti su temi così sfidanti. Le capacità assunte da soluzioni AI ed algoritmi, contestualmente alla rapida diversificazione degli ambiti di applicazione di tali sistemi, stanno fortemente e continuamente modificando gli scenari in cui possono verificarsi ripercussioni negative sulla sicurezza. Usi impropri della tecnologia possono estendere gli ambiti già noti delle possibili minacce, introdurne nuove tipologie e cambiarne profondamente le caratteristiche. La disponibilità e la diffusione di sistemi AI si sta specializzando in un loro uso, e una loro contrapposizione, sia come strumenti di attacco che di difesa.

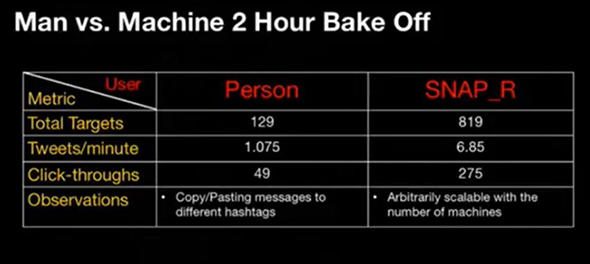

Diretta conseguenza di questa contrapposizione non saranno soltanto l’espansione e l’estensione delle minacce attualmente note, ma la nascita di tipologie di attacco inedite, sia realizzando fattivamente attacchi attualmente non realizzabili per limiti “umani”, sia scoprendone nuove forme, sia sfruttando vulnerabilità di sistemi di AI applicati ad infrastrutture e dati o posti a loro protezione. In primo luogo, infatti, ogni minaccia conosciuta può essere enormemente amplificata dall’utilizzo di strumenti di AI. Gli attacchi alla sicurezza informatica, se realizzati con strumenti di intelligenza artificiale – anziché essere portati a termine esclusivamente da esperti umani -, possono essere più facilmente replicabili. Quella che viene definita “scalabilità“, cioè la caratteristica di consentire la rapida crescita di automatizzazione delle soluzioni, può aumentare numericamente il numero dei bersagli (umani e non), degli attacchi e, più temibilmente, può affinare la precisione con la quale ogni singolo “target” può essere mirato da una particolare versione dell’attacco. In questo contesto, l’apprendimento dei motori di AI può essere infatti utilizzato per incrementare l’efficacia di ogni attacco e la personalizzazione di ogni attività in base al soggetto attaccato. Uno degli esempi più noti ed emblematici risale al 2016. Durante una delle più famose conferenze di hacking, “Black Hat security conference“, alcuni ricercatori hanno presentato e rilasciato pubblicamente il codice sorgente del tool “SNAP_R“che analizza i contenuti pubblicati da un utente, vittima designata, nel proprio account Twitter per generare nuovi tweet su argomenti attinenti ai temi più interessanti per quell’utente. Questi nuovi contenuti generati automaticamente risultano molto appetibili per la vittima e possono essergli inviati con altissima probabilità di lettura. Ai messaggi può essere poi aggiunto contenuto malevolo che l’utente finale non sarà probabilmente in grado di riconoscere come dannoso. Questa tecnica di attacco, basata soprattutto su vettori come le e-mail e definita “spear phishing”, risulta tanto più efficace quanto è più interessante per la vittima il messaggio che le viene inviato. Lo sforzo dell’attaccante è quindi quello di profilare al meglio il destinatario per poterne catturare l’attenzione ed indurlo a cliccare su quanto proposto. Si è dimostrato che automatizzare questo processo, tipicamente umano, ha aumentato sensibilmente i margini di successo dell’attaccante. Nella tabella che segue è evidente il vantaggio ottenuto dagli attaccanti in termini di contrazione dei tempi di realizzazione dell’attacco e di efficacia, misurata in numero di click sul link malevolo suggerito.

Più recentemente, alla Black Hat USA 2018 conference, IBM ha presentato il risultato di propri studi realizzati per esplorare la possibilità di utilizzo doloso di capacità e tecniche di AI. Lo strumento di attacco presentato, “DeepLocker“/), coniuga alcuni modelli di AI già esistenti con tradizionali tecniche di attacco utilizzate nei malware. In particolare, i ricercatori hanno alterato una tradizionale soluzione per videoconferenza nascondendo nel codice dell’applicazione un modulo AI per il riconoscimento facciale. L’identificazione visiva del target durante una conversazione audio/video è la funzione di attivazione che fa scattare un ulteriore modulo in grado di rendere completamente inutilizzabili i contenuti della macchina della vittima, cifrandoli. Un simile utilizzo di tecniche di intelligenza artificiale consente al modulo una estrema efficacia e ne aumenta sensibilmente la capacità di non essere identificato da strumenti di protezione “evasion capability”.

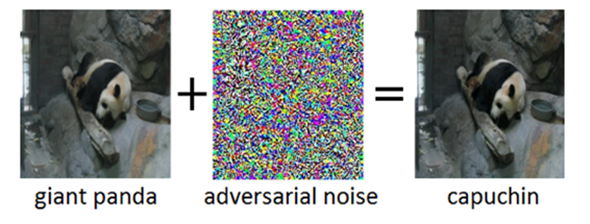

Scenari di attacco in cui sono presenti soluzioni “AI powered” dovranno essere sempre più considerati nello sviluppo di strumenti di protezione e nuove ricerche dovranno inoltre essere svolte sull’attaccabilità delle stesse soluzioni di difesa “AI based”. In alternativa potrebbero essere sfruttate delle vulnerabilità di cui soffrono i sistemi tecnologici ma che gli umani non avrebbero avuto. Sono già noti, ad esempio, attacchi di questo tipo per i sistemi di riconoscimento delle immagini. In alcuni recenti studi IBM, infatti, si dimostra come possano essere introdotte delle alterazioni nelle immagini osservate, anche umanamente non percettibili, in modo da ingannare i sistemi di image recognition. Nell’esempio che segue, è possibile evidenziare come un sistema di riconoscimento automatico di animali possa essere depistato aggiungendo un particolare disturbo visivo, quasi invisibile ad occhio umano.

Un’estensione della minaccia nel campo della “computer vision” è costituita dalla possibilità concreta di generare immagini sintetiche foto-realistiche e di fatto non distinguibili da foto reali. Tecniche simili possono essere utilizzate anche per generare audio, e quindi voci, o per mimare in modo automatico stile di scrittura o di comportamento di persone. Le conseguenze che ne derivano sono allarmanti; ad esempio, in ambito legale si dovrà contemplare il rischio che le prove visive ed audio siano state realizzate ad hoc in modo indistinguibile dalla realtà, e che quindi non possano più essere considerabili come “prove”. Inoltre, campagne informative o giornalistiche potranno essere progettate e realizzate coinvolgendo indirettamente l’immagine di persone influenti. Un esempio piuttosto noto risale allo scorso aprile. In un video dimostrativo ed ironico diffuso in internet l’attore americano Jordan Peele ha impersonificato addirittura il Presidente Obama.

In particolari contesti, tuttavia, la stessa definizione di “attacco” potrebbe risultare complessa e non universalmente riconosciuta. Infatti, può non essere sempre del tutto chiaro se tecniche e comportamenti in grado di ingannare o confondere strumenti automatici siano da considerare malevoli. Un esempio piuttosto singolare e provocatorio al delicato tema della videosorveglianza e delle sue implicazioni in termini di privacy e libertà personali è stato dedicato un noto articolo su come eludere gli strumenti di riconoscimento facciale utilizzando makeup e hairstyle. L’interrogativo è se questi atteggiamenti sono da considerarsi un attacco ai sistemi di videosorveglianza o una difesa della propria privacy.

Un’ulteriore esigenza esplicitata in “The Malicious Use of Artificial Intelligence: Forecasting, Prevention, and Mitigation” è la necessità di studi sistematici finalizzati a definire sia metodologie, sia tecniche di misurazione e valutazione della robustezza delle soluzioni AI. Inoltre si sottolinea come sia fondamentale implementare tecniche di “hardening” che rendano questo tipo di applicazioni più resistenti a possibili attacchi. Se poi pensiamo all'”attribuzione dell’attacco”, non mancano ulteriori complicazioni, dal momento che già attualmente è difficile avere evidenze in grado di corroborare, con indicazioni non soltanto tecniche ma anche economiche e geo-politiche, l’attribuzione di attacchi a specifici gruppi o a particolari Paesi.

Nelle linee guida suggerite per la mitigazione delle problematiche sollevate in ambito AI è spesso richiamata la necessità di “awareness”, della responsabilità, non soltanto con diretto riferimento a ricercatori e produttori di tecnologia ma con estensione ai fruitori, ai clienti, ai consumatori. Nella produzione, sia di software che di hardware, possono essere applicati, o estesi, le procedure ed i controlli già presenti in altri ambiti; ad esempio si pensi alle restrizioni sulla vendita di droni “potenzialmente letali”. Inoltre si possono introdurre norme di verifica e certificazione di meccanismi che rendano impossibile o limitato l’utilizzo di tecnologie AI in particolari condizioni. Sempre tenendo i droni come esempio, si può far riferimento a norme che forzino la verifica dell’efficacia dei meccanismi di “no fly zones” impostate per aree particolarmente sensibili (come già accade per i voli in prossimità degli aeroporti per mitigare il rischio di collisioni, intenzionali o meno).

In molte comunità scientifiche l’atteggiamento di attenzione alla responsabilità sociale è già preso molto seriamente. In ambito aziendale il timore è che la definizione di politiche di condivisione, di accesso limitato alle informazioni e di livelli di “disclosure” differenziati sia dettata maggiormente da considerazioni connesse alla competizione e che rischino di essere una giustificazione alla mancanza di trasparenza. Enti di ricerca, aziende e gruppi di studi governativi dovrebbero essere quindi chiamati a collaborare alla definizione di “dichiarazioni etiche” e ad assumere la funzione di catalizzatore per la definizione di standard ampiamente condivisi.

————-